Plataforma de Web Scraping

Descripción

Esta plataforma de web scraping fue diseñada para extraer, procesar y estructurar datos de múltiples fuentes web de manera eficiente, escalable y respetuosa con los sitios objetivo.

Desarrollada íntegramente en Python, la plataforma utiliza bibliotecas como Scrapy, Beautiful Soup y Selenium para adaptarse a diferentes tipos de sitios web, desde páginas estáticas simples hasta aplicaciones web complejas con contenido generado dinámicamente mediante JavaScript.

La arquitectura del sistema está diseñada para distribuir las tareas de scraping entre múltiples trabajadores, respetando las políticas de robots.txt, implementando retrasos adaptativos y rotación de proxies para minimizar el impacto en los sitios objetivo. Además, incluye capacidades avanzadas de procesamiento de datos para limpiar, normalizar y estructurar la información extraída.

Tecnologías Utilizadas

Python

Lenguaje principal para el desarrollo de scrapers y procesamiento

Scrapy

Framework para web scraping de alto rendimiento

Selenium

Automatización de navegadores para sitios dinámicos

MongoDB

Almacenamiento de datos extraídos en formato flexible

RabbitMQ

Sistema de colas para distribuir tareas de scraping

Pandas

Procesamiento y transformación de datos extraídos

Desafíos

Sitios dinámicos

Extraer datos de sitios web modernos que cargan contenido dinámicamente con JavaScript.

Escalabilidad

Diseñar un sistema que pudiera escalar para extraer datos de miles de sitios simultáneamente.

Detección de cambios

Identificar y adaptarse automáticamente a cambios en la estructura de los sitios web objetivo.

Soluciones

Enfoque híbrido

Implementé un sistema que combina Scrapy para sitios estáticos y Selenium para sitios dinámicos, seleccionando automáticamente el enfoque óptimo.

Arquitectura distribuida

Desarrollé una arquitectura basada en trabajadores distribuidos con RabbitMQ que permite escalar horizontalmente las tareas de scraping.

Aprendizaje adaptativo

Implementé algoritmos de machine learning en Python que detectan cambios en la estructura de las páginas y ajustan los selectores automáticamente.

Galería

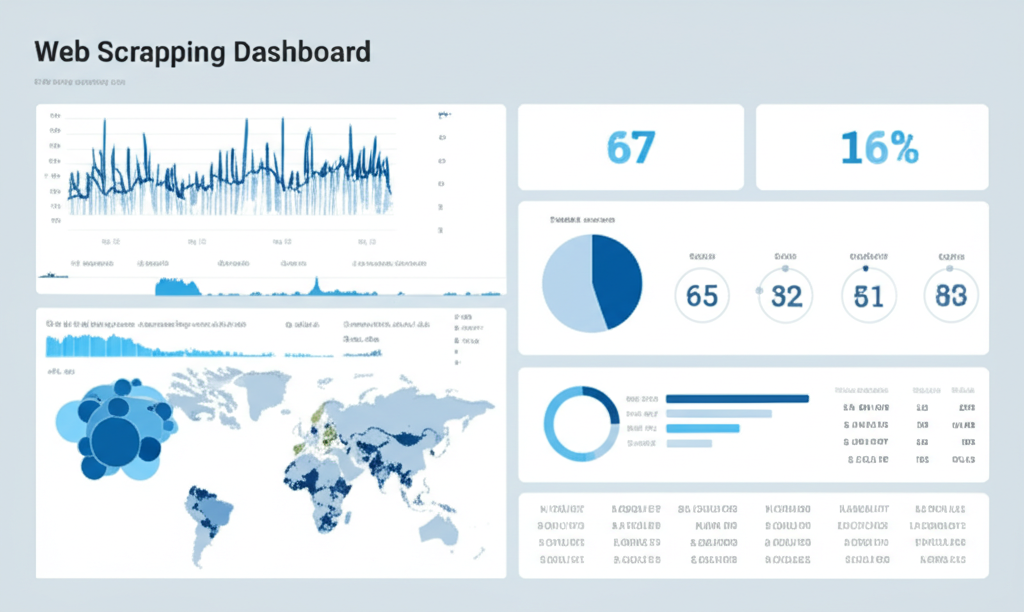

Dashboard de monitoreo de tareas de scraping

Pipeline de extracción y procesamiento de datos

Visualización de datos estructurados extraídos

Ejemplo de Código

import pandas as pd

import numpy as np

from typing import Dict, List, Optional

class DataProcessor:

"""

A class for processing and analyzing data.

"""

def __init__(self, data_path: str):

"""

Initialize the DataProcessor with a data file.

Args:

data_path: Path to the data file

"""

self.data_path = data_path

self.data = self._load_data()

def _load_data(self) -> pd.DataFrame:

"""

Load data from the specified path.

Returns:

DataFrame containing the loaded data

"""

try:

return pd.read_csv(self.data_path)

except Exception as e:

print(f"Error loading data: {e}")

return pd.DataFrame()

def clean_data(self) -> pd.DataFrame:

"""

Clean the data by removing duplicates and handling missing values.

Returns:

Cleaned DataFrame

"""

# Remove duplicates

self.data = self.data.drop_duplicates()

# Handle missing values

for column in self.data.columns:

if self.data[column].dtype == np.number:

self.data[column].fillna(self.data[column].median(), inplace=True)

else:

self.data[column].fillna(self.data[column].mode()[0], inplace=True)

return self.data

def analyze_data(self) -> Dict[str, any]:

"""

Perform basic analysis on the data.

Returns:

Dictionary containing analysis results

"""

results = {

"row_count": len(self.data),

"column_count": len(self.data.columns),

"summary_stats": self.data.describe().to_dict(),

"missing_values": self.data.isnull().sum().to_dict()

}

return results

def filter_data(self, conditions: Dict[str, any]) -> pd.DataFrame:

"""

Filter data based on specified conditions.

Args:

conditions: Dictionary of column-value pairs to filter by

Returns:

Filtered DataFrame

"""

filtered_data = self.data.copy()

for column, value in conditions.items():

if column in filtered_data.columns:

filtered_data = filtered_data[filtered_data[column] == value]

return filtered_data

# Example usage

if __name__ == "__main__":

processor = DataProcessor("data.csv")

cleaned_data = processor.clean_data()

analysis_results = processor.analyze_data()

print(f"Data has {analysis_results['row_count']} rows and {analysis_results['column_count']} columns")

# Filter data example

filtered = processor.filter_data({"category": "A"})

print(f"Filtered data has {len(filtered)} rows")

Habilidades Python

¿Interesado en un proyecto similar?

Si estás buscando implementar una solución en Python o tienes un proyecto en mente que requiera habilidades de desarrollo similares, no dudes en contactarme para discutir cómo puedo ayudarte.

Contactar